Verlässliche Daten mit Civey

Kooperationen und Mitgliedschaften

Unsere Methodik in vier Schritten

Netzwerkbasierte Panel-Rekrutierung

Verifizierung der Teilnehmer

Quotierte Stichprobe unverzerrter Antworten

Gewichtung in Echtzeit

Wir verbinden Innovation mit Validität

Hohe Beteiligung

- Die Bevölkerung wird in ihrer ganzen Breite erreicht.

- Teilnehmer werden mit frei verfügbaren Ergebnissen, statt mit Geld incentiviert.

- Die große Flexibilität bei der Erhebung steigert die Teilnahmebereitschaft.

Erhebungen in Echtzeit

- Algorithmen verifizieren und gewichten rund um die Uhr.

- Repräsentative Ergebnisse werden vollständig automatisiert ermittelt.

- Sowohl einmalige Umfragen als auch permanentes Live-Monitoring möglich.

Verlässliche Daten

- Anonyme Befragungen ohne monetäre Anreize fördern ehrlichere Antworten.

- Algorithmus identifiziert Manipulationsversuche und schließt Teilnehmer aus.

- Sicherheit für Teilnehmer und Kunden durch verschlüsselte Datenübertragung.

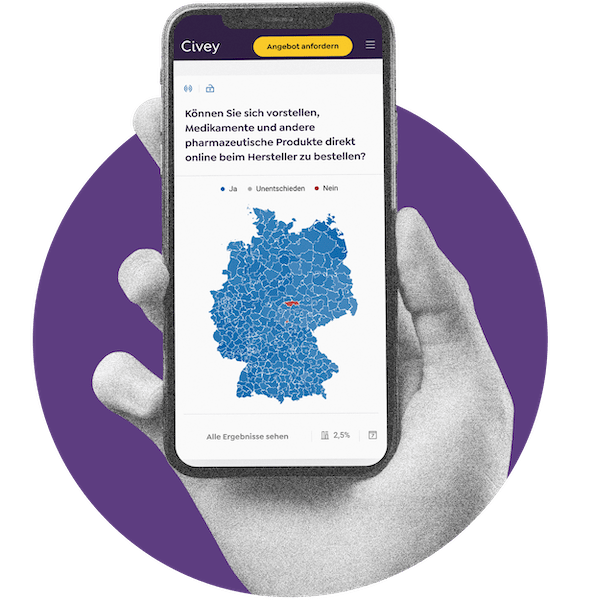

Verlässliche Regionaldaten mit Small Area Methoden

Small Area Methoden bei Civey

Für die Berechnung von Daten bis auf Landkreisebene nutzt Civey Small Area Methoden (SAM), die bereits vielfach international zum Einsatz kommen und bei Civey auf ein Echtzeit-Modell übertragen wurden. Dazu werden die Ergebnisse bis auf Landkreise auf Basis einer modellbasierten, statistischen Methode für kleine Datenräume erhoben.

- Grundlage ist eine bundes- oder bundeslandweite repräsentative Online-Befragung mit einer großen Stichprobe.

- Das Befragungsergebnis wird vom Algorithmus fortlaufend auf 13 persönliche Variablen sowie rund fünfzig regionale Daten analysiert.

- Der Algorithmus verbindet die entscheidenden Variablen mit einem jeweiligen Relevanzfaktor und bildet daraus ein individuelles Variablenset.

- Der Algorithmus analysiert parallel die Bevölkerungsstruktur in der Zielregion und berechnet, welches Antwortverhalten auf bestimmte Gruppen wie beispielsweise einen 19-jährigen Azubi oder eine 72-jährige Rentnerin in der Zielregion zutreffen.

- Abschließend findet eine Gewichtung anhand offizieller Bevölkerungsstatistiken statt.

Das hier dargestellte Verfahren basiert auf dem oft angewendeten Verfahren der Mehrebenen-Regression und Poststratifizierung (kurz MRP), auf das Civey setzt. Einige Modellierungen bei Civey erfolgen nach dem Fay-Herriot-Verfahren.

Small Area Methoden im weltweiten Einsatz

Small Area Methoden (SAM) finden bereit seit Jahrzehnten breite Anwendung. Gerne stellen wir hier einige Beispiele vor:

- Small Area Methoden (SAM) in der politischen Meinungsforschung: Einige Institute (z.B. Infas360, YouGov) arbeiten mit Small Area Methoden in Deutschland oder weltweit. Insbesondere das von Civey mit angewandte MRP-Verfahren kommt bei der Analyse relevanter Wahlen in den USA und Großbritannien zum Einsatz.

- Konkrete Politik-Entscheidungen basieren auf SAM. Das American Census Bureau berechnet mit dieser Methodik die amtliche Statistik zu Einkommen und Armut auf regionaler Ebene. Die Verteilung von US-Bundesgeldern, bspw. im so genannten SAIPE-Programm, erfolgt auf Basis von SAM-Daten.

- In Deutschland und weltweit wird SAM erforscht und gefördert. Destatis publiziert eigene Veröffentlichungen zu SAM. Auch die niederländische Statistik-Behörde veröffentlicht Abhandlungen über die Methode. Die EU fördert die Forschung von Small Area Methoden umfangreich. Zudem erforschen das American Census Bureau und Statistics Canada in zahlreichen weiteren Projekten den Einsatz von Small Area Methoden.

Fachdebatte

Civey-Gründer und Geschäftsführer Gerrit Richter und CPO Charlotte Weber erläutern auf marktforschung.de Small Area Methoden.

Unser Beirat

Brigitte Zypries

Ehem. Bundesministerin für Wirtschaft & Energie sowie für Justiz & Verbraucherschutz

Brigitte Zypries war 2002 bis 2009 Bundesministerin der Justiz & Verbraucherschutz, 2017 bis 2018 Bundesministerin für Wirtschaft & Energie und über zehn Jahre Mitglied des Deutschen Bundestages.

Joachim Koschnicke

Partner bei Finsbury Glover Hering sowie Gründer und Vorstand von InCharge e.V.

Joachim Koschnicke ist Partner und leitet den Geschäftsbereich Corporate Affairs & Public Strategies bei der Kommunikationsagentur Hering Schuppener. Zuvor war Koschnicke Geschäftsführer von forsa.

Prof. Dr. Anselm Hager

Institut für Sozialwissenschaften, Humboldt-Universität Berlin

Prof. Dr. Anselm Hager ist Juniorprofessor für Internationale Politik am Institut für Sozialwissenschaftenan der Humboldt-Universität Berlin. Zuvor lehrte er politische Ökonomie an der Universität Konstanz.

Prof. Dr. Jörg Müller-Lietzkow

Präsident HafenCity Universität, Hamburg

Prof. Dr. Jörg Müller-Lietzkow ist seit 2019 Hochschulpräsident der HafenCity Universität in Hamburg. Darüber hinaus ist er seit 2014 Co-Sprecher/Vorsitzender des cnetz e.V.

Prof. Dr. Ulrich Rendtel

Institut für Statistik und Ökonometrie, Freie Universität Berlin

Prof. Dr. Ulrich Rendtel forscht und unterrichtet seit 2003 als Professor für Statistik und Ökonometrie an der Freien Universität Berlin. Zu seinen Schwerpunkten zählen unter anderem Umfragen, Non-Response und Panel-Befragungen.

Prof. Dr. Oliver Serfling

Lehrstuhl für Wirtschaftspolitik und Entwicklungsökonomik, Hochschule Rhein-Waal

Prof. Dr. Oliver Serfling ist Mitgründer von Civey und Chief Scientific Advisor von Civey. Der promovierte Volkswirt hat den Lehrstuhl für Wirtschaftspolitik und Entwicklungsökonomik an der Hochschule Rhein-Waal inne und ist Experte für Statistik und Umfrageforschung.